MIT

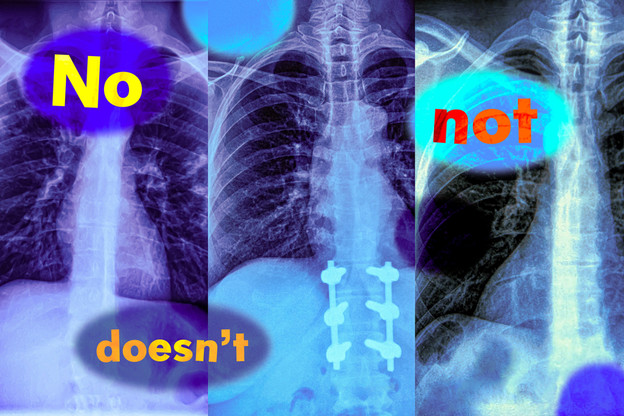

Vizualni AI modeli ne razumiju negaciju

Istraživači su otkrili da modeli vizualnog jezika čine pogreške u stvarnim situacijama jer ne razumiju negaciju, odnosno riječi poput "ne".

Istraživači s Instituta tehnologije u Massachusettsu MIT-a, otkrili su da modeli vizualnog jezika (VLM-ovi), koji se široko koriste za analizu medicinskih slika radi pojednostavljenja dijagnoze, ne razumiju riječi negacije poput „ne“.

Zamislite radiologa koji pregledava rendgensku snimku prsnog koša novog pacijenta. Primjećuje da pacijent ima oticanje tkiva, ali nema povećano srce. Kako bi ubrzao dijagnozu, mogao bi koristiti model strojnog učenja vizualnog jezika kako bi pretražio izvješća sličnih pacijenata.

Ali ako model pogrešno identificira izvješća s oba stanja, najvjerojatnija dijagnoza mogla bi biti sasvim drugačija. Ako pacijent ima oticanje tkiva i povećano srce, stanje je vrlo vjerojatno povezano sa srcem, ali bez povećanja srca moglo bi postojati nekoliko temeljnih uzroka.

U novoj studiji, istraživači MIT-a otkrili su da modeli vizualnog jezika vjerojatno čine takvu pogrešku u stvarnim situacijama jer ne razumiju riječi s negacijom, koje specificiraju što je lažno ili odsutno.

„Te riječi negacije mogu imati vrlo značajan utjecaj, a ako samo slijepo koristimo ove modele, mogli bismo se suočiti s katastrofalnim posljedicama“, kaže Kumail Alhamoud, diplomirani student MIT-a i glavni autor ove studije.

Istraživači su testirali sposobnost modela vizualnog jezika da identificiraju negaciju u opisima slika. Modeli su se često ponašali jednako dobro kao i slučajno pogađanje. Nadovezujući se na te nalaze, tim je stvorio skup podataka o slikama s odgovarajućim opisima koji uključuju riječi negacije koje opisuju nedostajuće objekte.

Pokazuju da ponovno treniranje modela vizualnog jezika s ovim skupom podataka dovodi do poboljšanja performansi kada se od modela traži da dohvati slike koje ne sadrže određene objekte. Također povećava točnost pri odgovaranju na pitanja s višestrukim izborom s negiranim opisima.

No istraživači upozoravaju da je potrebno više rada kako bi se riješili uzroci ovog problema. Nadaju se da će njihovo istraživanje upozoriti potencijalne korisnike na prethodno nezapaženi nedostatak koji bi mogao imati ozbiljne implikacije u okruženjima s visokim ulozima gdje se ovi modeli trenutno koriste, od određivanja koji pacijenti primaju određene tretmane do identificiranja nedostataka proizvoda u proizvodnim pogonima.

Jedan od razloga ovog neuspjeha je prečac koji istraživači nazivaju pristranošću afirmacije. VLM-ovi ignoriraju riječi negacije i umjesto toga se usredotočuju na objekte na slikama.

„To se ne događa samo za riječi poput 'ne', jer će bez obzira na to kako izražavate negaciju ili isključenje, modeli to jednostavno ignorirati“, kaže Alhamoud.

Budući da VLM-ovi obično nisu obučeni na opisima slika s negacijom, istraživači su razvili skupove podataka s riječima negacije kao prvi korak prema rješavanju problema.

Koristeći skup podataka s 10 milijuna parova opisa slika i teksta, potaknuli su LLM da predloži povezane opise koji specificiraju što je isključeno iz slika, što je rezultiralo novim opisima s riječima negacije.

Morali su biti posebno oprezni da se ti sintetički titlovi i dalje čitaju prirodno, inače bi VLM mogao zakazati u stvarnom svijetu kada se suoči sa složenijim titlovima koje su napisali ljudi.

Otkrili su da fino podešavanje VLM-ova s njihovim skupom podataka dovodi do poboljšanja performansi u svim područjima. Poboljšalo je sposobnosti modela za pronalaženje slika za oko 10 posto, a istovremeno je povećalo performanse u zadatku odgovaranja na pitanja s višestrukim izborom za oko 30 posto.

„Ali naše rješenje nije savršeno. Samo rekapituliramo skupove podataka, oblik proširenja podataka. Nismo se čak ni dotakli načina na koji ovi modeli funkcioniraju, ali se nadamo da je ovo signal da je ovo rješiv problem i da drugi mogu uzeti naše rješenje i poboljšati ga“, kaže Alhamoud.

U budućnosti bi istraživači mogli proširiti ovaj rad podučavanjem VLM-ova da odvojeno obrađuju tekst i slike, što bi moglo poboljšati njihovu sposobnost razumijevanja negacije. Osim toga, mogli bi razviti dodatne skupove podataka koji uključuju parove slika i opisa za specifične primjene, poput zdravstva.

Učitavam komentare ...