Cerebras Systems

Predstavljen najveći procesor na svijetu

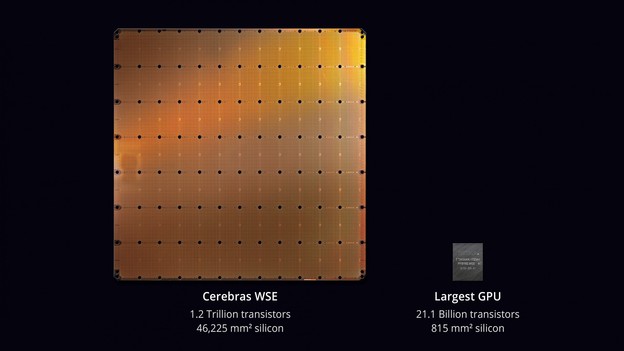

Novi čip sadrži 1,2 bilijuna tranzistora i za 56 puta je veći od današnjeg najvećeg procesora.

Većina današnjih čipova sastoji se od kolekcije procesora koji su napravljeni na 12-inčnim silicijskim waferima, no američki startup Cerebras Systems napravio je jedan čip koji se proteže na čitavom waferu. Čip je dizajniran tako da sve interkonekcije na njemu rade na velikim brzinama te da više od bilijun tranzistora radi zajedno kao jedan.

Drugim riječima Cerebras Systems je predstavio najveći procesor na svijetu, koji se sastoji od 1,2 bilijuna tranzistora i veći je 56 puta od današnjeg najvećeg čipa.

Za usporedbu Intelov prvi 4004 procesor iz 1971. godine ima 2.300 tranzistora, dok najnoviji AMD-ov sadrži 32 milijarde.

Taj procesor pod nazivom Cerebras Wafer Scale (CWS) Engine koji je izrađen specijalno je za umjetnu inteligenciju, sastoji se od 400.000 jezgri raspoređenih na pločici veličine od 46.225 kvadratnih milimetara i 56,7 puta je veći od najvećeg Nvidijinog GPU-a koji na površini od 815 kvadratnih milimetara sadrži 21,1 milijardu tranzistora.

Pored toga, novi čip je 3.000 brži a njegova ugrađena memorija ima 33.000 puta veću propusnost.

Mada se čipovi nastoje učiniti čim manjim, u ovom slučaju veličina je bila bitna za AI, jer veći procesori procesiraju informacije znatno brže i trebaju puno manje vremena za odgovor.

Zahvaljujući takvom dizajnu, CWS znatno smanjuje "vrijeme treniranja" za uvježbavanje neuralnih mreža, modela strojnog i dubokog učenja, što bi stručnjacima za umjetnu inteligenciju trebalo omogućiti da isprobavaju više ideja, koriste više podataka i rješavaju nove probleme.

"Od osnove dizajniran za AI, Cerebras WSE sadrži fundamentalne inovacije rješavanjem izazova starih nekoliko desetljeća koji su bili limitirani veličinom čipa, izjavio je osnivač i CEO tvrtke Andrew Feldman. "Sve odluke o arhitekturi donijeli smo s ciljem optimizacije AI procesa, a to je rezultiralo stotinama ili tisućama puta boljim performansama u odnosu na postojeća rješenja uz sićušnu potrošnju energije i prostora".

Feldman kaže da su ta poboljšanja performansi ostvarena ubrzanjem svih elemenata treninga neuralnih mreža, što će u konačnici dovesti do velikog iskoraka u umjetnoj inteligenciji.

Učitavam komentare ...