MIT

Sustav temeljen na simulaciji za spretne robote

Sustav PhysicsGen pomaže robotima u rukovanju predmetima u domovima i tvornicama prilagođavanjem podataka o obuci.

Kada ChatGPT ili Gemini daju ono što se čini kao stručni odgovor na vaša goruća pitanja, možda ne shvaćate na koliko se informacija oslanjaju da bi dali taj odgovor. Poput drugih popularnih generativnih modela umjetne inteligencije, ovi chatbotovi oslanjaju se na okosnice sustava zvane temeljni modeli koji se obučavaju na milijardama, ili čak bilijunima podatkovnih točaka.

Slično tome, inženjeri se nadaju izgraditi temeljne modele koji će obučavati niz robota novim vještinama poput podizanja, premještanja i spuštanja predmeta na mjestima poput domova i tvornica. Problem je što je teško prikupljati i prenositi podatke o uputama između robotskih sustava.

Sustav biste mogli obučavati teleoperiranjem hardvera korak po korak koristeći tehnologiju poput virtualne stvarnosti (VR), ali to može oduzeti puno vremena. Obuka na videozapisima s interneta manje je poučna jer isječci ne pružaju detaljan, specijalizirani vodič za određene robote.

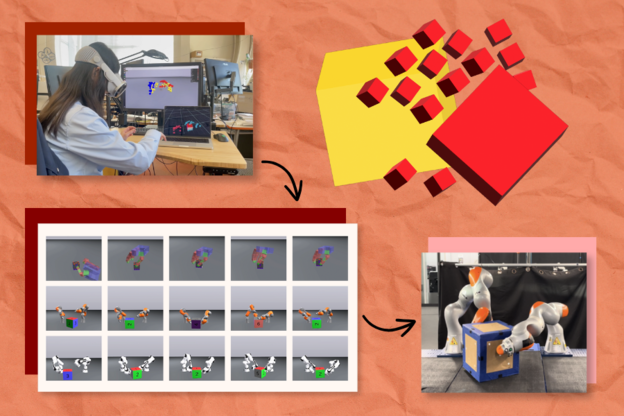

Pristup vođen simulacijom nazvan "PhysicsGen" iz MIT-ovog Laboratorija za računalne znanosti i umjetnu inteligenciju (CSAIL) i Instituta za robotiku i umjetnu inteligenciju, prilagođava podatke o obuci robota kako bi pomogao robotima da pronađu najučinkovitije pokrete za zadatak. Sustav može umnožiti nekoliko desetaka VR demonstracija u gotovo 3000 simulacija po stroju. Ove visokokvalitetne upute zatim se mapiraju na precizne konfiguracije poput robotskih ruku i šaka.

PhysicsGen stvara podatke koji se generaliziraju na specifične robote i uvjete putem trostupanjskog procesa. Prvo, VR naočale prate kako ljudi manipuliraju objektima poput blokova koristeći ruke. Te se interakcije istovremeno mapiraju u 3D simulatoru fizike, vizualizirajući ključne točke naših ruku kao male sfere koje odražavaju naše geste. Na primjer, ako biste okrenuli igračku, vidjeli biste 3D oblike koji predstavljaju različite dijelove vaših ruku rotirajući virtualnu verziju tog objekta.

Sustav zatim preslikava te točke na 3D model postavke određenog stroja (poput robotske ruke), pomičući ih do preciznih "zglobova" gdje se sustav okreće i okreće. Konačno, PhysicsGen koristi optimizaciju putanje, simulirajući najučinkovitije pokrete za dovršetak zadatka, tako da robot zna najbolje načine za izvođenje stvari poput premještanja kutije.

Svaka simulacija je detaljna podatkovna točka za obuku koja robota vodi kroz potencijalne načine rukovanja objektima. Kada se implementira u akcijski plan koji robot slijedi, stroj ima niz načina pristupa zadatku i može isprobati različite pokrete ako jedan ne funkcionira.

"Stvaramo podatke specifične za robote bez potrebe da ljudi ponovno snimaju specijalizirane demonstracije za svaki stroj", kaže Lujie Yang, doktorandica elektrotehnike i računarstva na MIT-u i CSAIL-u, koja je glavna autorica novog rada koji predstavlja projekt.

Generiranje toliko mnogo instrukcijskih putanja za robote moglo bi na kraju pomoći inženjerima da izgrade ogroman skup podataka za vođenje strojeva poput robotskih udova i spretnih ruku. Na primjer, sustav bi mogao pomoći dvjema robotskim rukama da surađuju pri preuzimanju skladišnih predmeta i njihovom smještanju u prave kutije za dostavu. Sustav bi također mogao voditi dva robota da rade zajedno u kućanstvu na zadacima poput odlaganja šalica.

Potencijal PhysicsGena proteže se i na pretvaranje podataka dizajniranih za starije robote ili različita okruženja u korisne upute za nove strojeve. "Unatoč tome što su podaci prikupljeni za određenu vrstu robota, možemo oživjeti ove prethodne skupove podataka kako bismo ih učinili općenito korisnima", dodaje Yang.

Yang i njezini kolege prvo su testirali svoj sustav u virtualnom eksperimentu gdje je lebdeća robotska ruka trebala rotirati blok u ciljni položaj. Digitalni robot izvršio je zadatak s točnošću od 81 posto trenirajući na ogromnom skupu podataka PhysicGena, što je poboljšanje od 60 posto u odnosu na početnu vrijednost koja je učila samo iz ljudskih demonstracija.

Istraživači su također otkrili da PhysicsGen može poboljšati način na koji virtualne robotske ruke surađuju kako bi manipulirale objektima. Njihov sustav stvorio je dodatne podatke za treniranje koji su pomogli dvama parovima robota da uspješno izvršavaju zadatke čak 30 posto češće nego u isključivo ljudskoj početnoj vrijednosti.

U eksperimentu s parom robotskih ruku iz stvarnog svijeta, istraživači su primijetili slična poboljšanja dok su se strojevi udruživali kako bi okrenuli veliku kutiju u određeni položaj. Kada bi roboti odstupili od predviđene putanje ili pogrešno rukovali objektom, mogli su se oporaviti usred zadatka pozivanjem na alternativne putanje iz svoje biblioteke nastavnih podataka.

Yang i njezini kolege također žele učiniti PhysicsGen još korisnijim za robote različitih oblika i konfiguracija u budućnosti. Kako bi to ostvarili, planiraju iskoristiti skupove podataka s demonstracijama stvarnih robota, bilježeći kako se robotski zglobovi kreću umjesto ljudskih.

Za sada, PhysicsGen pokazuje kako nam umjetna inteligencija može pomoći da naučimo različite robote manipulirati objektima unutar iste kategorije, posebno krutim. Sustav bi uskoro mogao pomoći robotima da pronađu najbolje načine za rukovanje mekim predmetima (poput voća) i deformabilnim (poput gline), ali te interakcije još nije lako simulirati.

Učitavam komentare ...